ANACONDAをインストールして、Jupyter Notebookでプログラムコードを打ち込みながらPythonを勉強しています。

Jupyter Notebookは、ブラウザ上で動作するプログラムの対話型実行環境です。

C#やJavaを学習してきた私からすると、Pythonは人の感覚との親和性が高い言語です。

言語として分かりやすいし、ライブラリーが充実しているので複雑なことを簡単に実現できます。

Pythonを使ってやりたいことは、ネット上にあるデータの収集(スクレイピング)、加工、分析です。

とはいえ、どんなデータを収集、加工、分析するのか、決まっていません。

ネット上には膨大なデータがあるので、対象とするデータを絞り込めていないというところです。

分析のためには、統計的な処理を施す必要があります。

統計学についても、基本的なところは押さえておきたいところです。

父の介護保険の更新やデイサービスの手続きも済んだので、少しだけですが、まとまった時間がとれるようになりました。

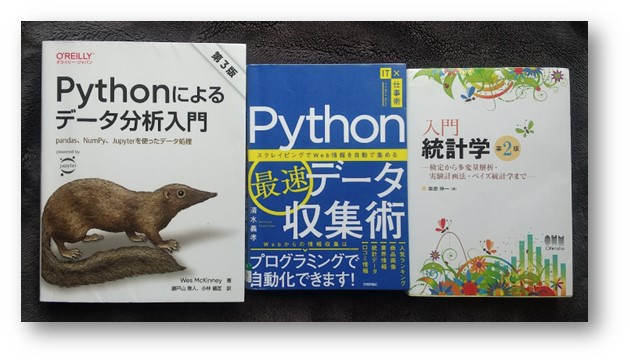

以下の本で勉強中です。

「Python最速データ収集術~スクレイピングでWeb情報を自動的に集める」 清水義孝著 技術評論社

「Pythonによるデータ分析入門」 Wes Mckinney著 瀬戸山 雅人、小林 儀匡 訳 オーム社

「入門 統計学」 栗原 伸一著 オーム社

勉強だけしていても身につかないので、まずは、練習用に対象データを決めてスクレイピングと加工、分析をして、身につけていきたいと思っています。